인간이 보는 것

인간이 보는 것의 대부분은 착시일지도 모른다. 아이러니하게도 우리는 불안정한 시력 덕분에 놀라운 기술혁신을 할 수 있었다. 원근감과 동영상을 살펴보자.

회화에서 (투시)원근법이 적용된 건 15세기 르네상스 시대 이후로, 얼마 되지 않았다. 원근법은 3차원의 사물을 2차원의 공간에 넣기 위한 방법으로 한 장소에 화가가 고정하고 그리고자 하는 대상(객체)을 특정 도구 등(도구가 없을 경우 소실점 지정) 도움을 받아 투영하여 그린다. 도움을 받아 3차원을 2차원으로 그리는 이유는 인간의 시각 인지능력이 2차원에 머물고 있기 때문이다. 보다 정확히 말하면 인간은 두 눈으로 2차원 평면에서 깊이를 더해 인지한다.

원근 착시, 인간의 시각은 2차원이다

이는 인간의 시각이 ‘빛’에 반사하는 대상 면만 인식하기 때문이다. 인간이 3차원을 인식하는 건 ‘촉각’으로 매우 제한적으로 인식할 수 있다. 애플이 누름(촉각) 강도에 따라 반응하는 터치인터페이스의 이름을 ‘3D터치’라고 명명한건 그러한 이유 때문이다.

원근감과 더불어 인간의 착시 중에 대표적인 것이 바로 ‘동영상’이다. 우리가 흔히 보는 영화, 애니메이션이 1초에 24장의 스틸컷(정지화면)을 연속하여 출력하여 만들어진 컨텐츠다. 즉, 인간은 1초에 24장의 변화된 정지화면을 보면 움직이는 것으로 인지한다.(24fps는 유성 영화에서 음성 퀄리티를 유지하기 위한 최소 프레임이다.) NTSC TV환경 그리고 추후 디지털 환경으로 넘어오면서 30Hz 혹은 60Hz 등 주사율로 되는데 이는 1초에 화면 변경이 30번 혹은 60번 화면 재생이 되는 것을 말한다.

FPS 차이

2차원만 인지하고 적은 정보만으로도 움직임을 착시하는 인간의 어설픈 시각이 광학(빛) 기술을 발전하게했다. 시각과 그에 상응하는 기술로 인류는 가장 놀라운 사진과 영화의 ‘컨텐츠’를 만들어 냈다.

인간이 보는 컨텐츠

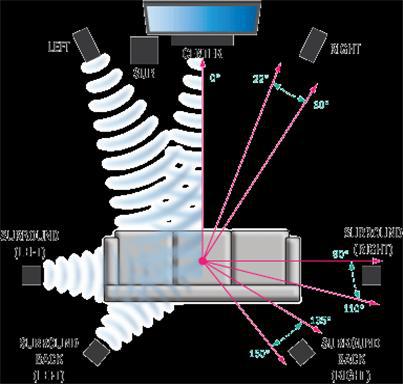

7.1 채널 오디오: 음악만 들을 때 필요할까?

보는 것뿐 아니라 듣는 것에 있어서도 인간의 감각은 제한되어 있다. 5.1채널, 7.1채널 입체음향 스피커가 나왔지만 대부분 가정에서 듣는 스피커는 스테레오 스피커다. 단정해서는 안 되지만, 이는 인간의 귀가 2개이기 때문이 아닐까 싶다. 그리고 대부분 음악 컨텐츠는 2채널로 제한되어 있다. 아무리 여러 채널로 음원이 나와도 수요가 많지 않다. 현재의 사진과 영화 컨텐츠 또한 인간의 시각 능력으로 거의 완성된 것이 아닐까 싶다. 물론 해상도는 더 올라가는 등 기술적인 개선이 있겠지만 근본적인 변화가 일어나긴 어려울 것이다.

3D영화로 성공한 아바타

2009년 영화 아바타 성공적인 개봉 이후 3D영화는 대세가 되어 가정에 흑백에서 칼라로 이전했듯 3D TV가 대중화될 것처럼 보였다. 이후 3D 영화가 주기적으로 나왔지만 가정을 변화시키진 못했다. 3D영화를 보기 위해 컨텐츠도 부족하고, 전용 안경을 쓰는 번거로움도 있고, 어지러움 문제도 있지만 3D TV를 만드는 기업들이 인간의 시각에 대해 전혀 이해를 못했기 때문이 아닐까 싶다.

인간은 2D사진과 영상을 보면서 보이는 대상을 완전히 인식한다. 아니 보다 사실적으로 말해 그 이상을 이해할 수 없다. 인간이 사진과 영상 컨텐츠에서 원하는 건 3차원보다는 해상도(화질)다. 결국 기술 기업들은 영상 기술 적용에 있어 3D 영상 기술에서 4K 영상 기술로 이전하게 되었다. IT기업 중 유일하게 애플은 3D영상 기술을 철저하게 무시하였고 대신 Retina 디스플레이로 영상 등 해상도 경쟁에 불을 질러버렸다.

애플식 보여주기

애플은 새로운 기술을 상당히 '짜증 나는 방식'으로 적용한다. 수요 트렌드를 일부러 무시한다고 할까? 아바타로 인해 3D 영화가 대세가 될 것처럼 보였을 때 애플은 맥에 3D 영상 플레이를 하는 소프트웨어와 하드웨어 디스플레이를 선보이지 않았고 iTunes Store에 3D 영화를 선보이지 않았다. 지금도 마찬가지.

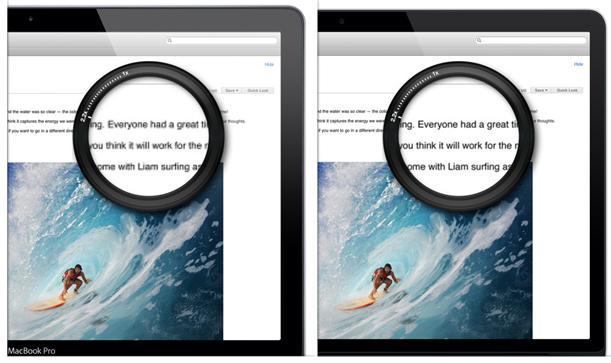

대신 애플은 아바타가 휩쓸고 간 다음 해인 2010년, 아이폰4에서 Retina 디스플레이를 선보인다. 그리고 아이폰 뿐 아니라 아이패드, 맥 제품 모두에 몇 년에 걸쳐 이 기술을 적용하였다. 레티나 다스플레이, 가장 오해받고 있는 기술이 아닐까 싶다. 단순히 디스플레이 해상도만 올리는 것이 아니다. 이 기술의 의의는 읽는 컨텐츠(문자)와 보는 컨텐츠(사진, 영상)를 OS에서 따로 처리한다는 데 있다. 해상도가 1920X1080인 모니터와 레티나 기술을 지원하는 3840X2160 모니터 있을 때 글자 크기는 두 모니터가 같지만 글자 선명도는 레티나 지원 모니터가 4배 선명하다. 반면 그림은 원본 해상도에 따라 결정된다. 해상도만 올라간다면 글자 크기는 1/4로 줄어들어 화면 레이아웃이 깨지게 되기에 기존의 출력 방식으로는 해결되지 않는다. 애플은 고해상도 모니터의 문제에 대한 상당히 탁월한 해결책을 제시한 것이다.

레티나 디스플레이는 글자와 그림을 따로 처리한다(맥북 프로)

애플은 왜 레티나 디스플레이에 집착하게 되었을까? 그건 종이 인쇄 매체 때문이다. 디스플레이 맹점은 픽셀이 도드라져 글자 자체가 뭉개져 보인다는 것이다. 종이 인쇄물처럼 불편하지 않게 보려면 픽셀 크기를 시각이 인지할 수 없을 정도로 작게 해야 한다. 애플은 인간의 보는 불편함을 간파하였고 그 결과가 바로 레티나디스플레이다.

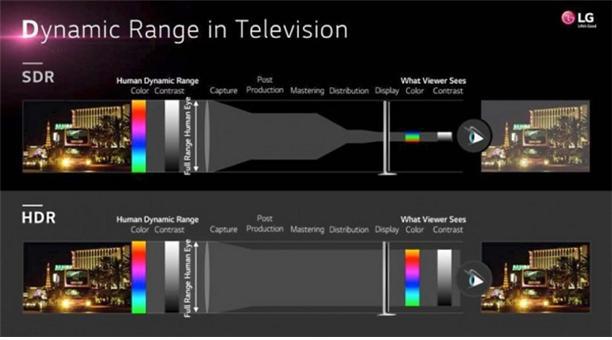

또한 애플은 2D 디스플레이를 한계까지 밀어붙이려고 한다. 확장된 색 표현 범위를 대응(Wide Color gamut)하는 애플 명칭, 와이드 칼러 디스플레이(Wide Color Display)를 작년부터 선보였다. iMac 5K (2015년 10월 모델), iPad Pro 9.7inch(2016년 3월) 그리고 iPhone 7(+)에 본 기술을 적용하고 있다. 물론 wide color gamut을 처음으로 지원한 기업은 애플이 아니다. 이 기술을 애플보다 먼저 적극적으로 선보이는 기업들은 HDTV 제조사다.

LG Wide Color Gamut 자료

하지만 애플은 이 기술 적용에 있어서 하드웨어뿐 아니라 소프트웨어적으로 변화를 이끌어내고 있다. 현존하는 대부분의 디지털 카메라는 색영역에 있어서 Wide Color Gamut을 지원하지 않고 있고 대부분의 그래픽 및 영상 소프트웨어 또한 이 기술을 지원하지 않고 있다. 애플은 이 기술을 레티나 디스플레이처럼 자사 OS 코어에 모두 적용하였다. 그럼으로써 관련 업계를 독려하고 있다.

레티나 디스플레이에서 종이 인쇄 매체에 도전하였다면 와이드 칼러 디스플레이에서는 인간이 구분할 수 있는 자연계 색영역을 디스플레이에서 적용하기 위해서이다.

레티나 디스플레이로 촉발된 스마트폰 고해상도 전쟁에서 애플은 오히려 한발 물러섰다. 이는 300dpi이상이 되면 인간의 시각으로 픽셀 구분이 어렵다고 판단했기 때문이다. 5인치 화면에 4K 영상 출력은 과분하긴 하다. 그 대신 애플은 인간이 인지할 수 있는 색영역에 관심을 가졌다. 애플은 무조건적인 스펙 경쟁이 아니라 인간의 감각에 대해 다른 기업과는 다른 접근을 하고 있다.

아이폰 7+의 카메라

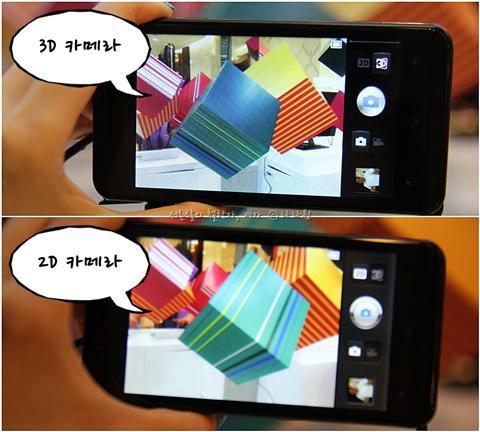

애플이 생각하는 보는 것은 무엇일까? 기술중심이 아닌 철저히 ‘컨텐츠’ 중심의 보는 것이다. 애플은 기능을 더하기보다는 빼기를 좋아한다. 근데 이번 아이폰 7+ 발표하면서 어쩌면 유일하게 덧붙인 게 있다. 바로 듀얼 카메라다. AP에 있어서 쿼드코어를 지원하지 않는 애플이 카메라는 듀얼로 했다. 물론 카메라 렌즈 두 개를 단 스마트폰이 아이폰이 최초는 아니다. LG 옵티머스 3D는 무려 5년 전 2011년에 듀얼 카메라를 도입했다. LG는 이름에서처럼 두 개의 카메라로 3D 영상을 촬영하고 시청 가능하다고 선전하였다. 하지만 이 제품은 소비자에게 철저하게 외면받게 된다. 후속작인 옵티머스 3D 큐브 또한 버스폰으로 전락하고 만다.

LG 옵티머스 3D로 3D 영상을 촬영하고 볼 수 있다.

HTC의 듀얼 카메라는 흐리게(blur) 혹은 후광 등 후편집 기능을 넣기 위해 두 번째 렌즈를 채용했다. 옵티머스로 개피 본 LG는 더이상 3D 촬영을 위한 듀얼 렌즈를 적용하지 않고 서로 다른 화각의 렌즈를 채용했다. 단 찍기 전에 수동으로 렌즈를 선택해야한다.

그렇다면 애플과 LG, HTC 등 듀얼 카메라와 다른 점이 무엇일까? 애플은 2015년 4월 이스라엘 카메라 업체 LinX를 인수했다. LinX가 가지고 있는 기술이 무엇이길래 애플이 인수했을까?

아이폰 7+의 듀얼 렌즈

다중 센서 기능, 광학 줌

카메라의 성능은 센서에 좌우되고, 센서 크기에 비례한다. 단 센서가 커지면 렌즈가 커지고 렌즈가 커지면 본체가 두꺼워진다. LinX는 센서의 크기를 키우는 대신 센서를 나누어 처리하는 기술을 개발했다. 즉, 두 개의 렌즈와 두 개의 센서를 달고 하나의 이미지를 조합하는 것이다. LG와 다른 점은 하드웨어적인 광학기술과 소프트웨어 기술이 통합되었다는 것이다. 사용자는 어느 렌즈를 사용할지 알 필요가 없다. 줌을 하고 촬영하면 그만이다.

코닥이 2016년 선보인 스마트폰, 센서 크기에 비례하여 렌즈가 커졌다

무엇보다 센서를 두 개로 나누면 카메라 성능을 올리면서 본체 두께를 유지할 수 있게 된다. 아이폰 7+는 광학줌은 2배 디지털 줌은 10배가 가능하게 되었다.

피사계 심도 효과

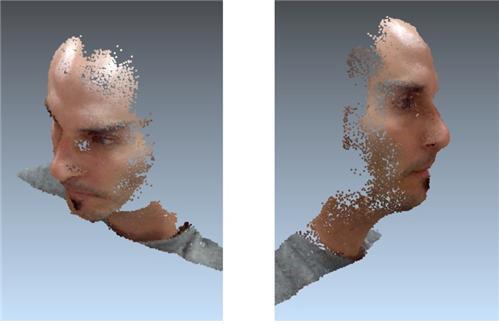

LinX 기술: 두 개의 렌즈로 3D 모델링이 가능

LinX는 두 개의 렌즈로 3D 모델링을 선보였다. 하지만 애플은 이 기술을 3D 모델링 보다는 피사계심도에 집중한다. 많은 경우 DSLR를 구매하는 이유는 밝은 렌즈 때문이다. 밝은 렌즈를 사용하여 촬영하게 되면 인물에 보다 초점에 맞추어 배경과 구분하여 선명하게 찍을 수 있다. 피사계심도를 조절하기 위해서는 초점거리를 조절하거나 조리개(aperture)값을 조정하는 등 렌즈 성능에 영향을 받는다. 스마트 폰 렌즈로 피사계심도를 후보정 없이 DSLR처럼 하는 건 지금까지 불가능하다.

아이폰 7+로 DSLR식 얕은 피사계 심도를 구현 가능하다.

애플은 LinX의 3D 모델링 기술을 가져와 대상(인물)과 배경을 나누는 기술로 접목시켰다. HTC처럼 후보정이 아니라 사진이 찍히자마자 바로 대상과 배경을 구분하여 피사계심도를 적용할 수 있게 한 것이다. 이 기술로 DSLR의 중요 기능을 실현하였다.

아이폰7+에서 두 개의 렌즈로 대상과 배경을 나눌 수 있는 기술을 선보였다

애플은 3D 촬영을 하거나 보여주는 데 관심이 없다. 그건 인간의 시각 인지능력을 너무도 잘 알고 있기 때문이다. 사용자가 원하는 건 컨텐츠다. 대상(인물)을 보다 또렷하게 보게 하는 것, 대상을 가까이 찍기 위해 줌으로 땡기든, 대상을 보다 도드라지게 배경을 날려버리든 말이다. 애플은 인간의 욕망에 대해 너무도 명확한 감각을 가지고 있다.

기대되는 기술들, 증강현실

외신에서 아이폰 7+에서 듀얼렌즈는 증강현실 기술의 근간이 될 것이다라고 언급했다. 팀쿡이 증강현실에 대하여 놓치고 있지 않다고 언급한 것을 보면 애플도 증강현실 기술에 관심이 있을 듯싶다. 대상과 배경을 나누는 기술로 거리의 모든 대상을 메타데이터화 할 수 있겠다.

증강현실은 현실 대상을 문자화(데이터화)하는 것이다

메타데이터는 데이터의 데이터이다. 데이터이지만 독립적으로 쓰일 수 없는 데이터가 메타데이터이다. 사진을 예를 들면 사진(데이터) 안에 파일명, GPS, 인물정보, 카메라 정보, 밝기 정보 등이 메타데이터이다. 사진과 메타데이터가 분리되면 메타데이터는 쓸모없게 된다. 그렇지만 메타데이터는 매우 강력하다. 메타데이터는 데이터베이스가 되는 문자열로 저장된다. 문자열이 된다는 건 ‘검색’이 가능하다는 것이다. 구글에서 특정 자료를 검색한다고 하면 구글은 문자열로 된 메타데이터를 우선 검색한다. 사진 데이터를 직접 검색하는 건 보다 많은 기술과 시간이 필요하다(최근 뜨고 있는 머신러닝이 바로 이 기술이다). 가령, 사용자가 찾기 쉽게 사진에 제목을 적었다면 굳이 머신러닝까지 필요가 없다. 메타데이터는 AI의 출발선에 있다.

증강현실은 거리의 모든 대상을 메타데이터화 하는 것이다. 63빌딩을 스마트폰 카메라로 비추면 화면에 63빌딩 이름이 나오고 각 층마다의 정보가 메타데이터가 되어 화면으로 보여준다. 아이폰 7+에서 대상과 배경을 나누는 기술은 대상을 인지하여 인식할 수 있는 기술이기 때문이다. 그런다 하여도 증강현실 등은 근미래의 거대 답론이고 애플의 궁극적인 카메라 사용은 ‘컨텐츠’ 중심이다.

애플식의 보는 것

애플은 기업으로 상품을 판매한다. 애플은 정말로 상품을 만든다. 그 상품을 누가 사는지 정확히 인지하고 있다. 3D 디스플레이, 3D 컨텐츠가 가정에 정착하지 못할 것을 애플이 알았는지 어쨌는지 모르겠지만 애플은 사람의 시각 능력이 현재의 3D 기술로 상품이 될 수 없다는 것을 알았다. 애플은 3D 기술을 활용은 하되 지금까지 사람들이 욕망해왔던 기능들을 실현하는 것에 집중했다. 아이폰 7+ 듀얼 카메라에서 광학 줌 기능과 피사계심도 기능은 이런 인간이 원하는 기능을 정확히 관통하고 있다. 애플의 듀얼 카메라는 뛰어난 상품이다.

10월 27일(한국시간 28일 새벽 2시) 애플 이벤트 초청장

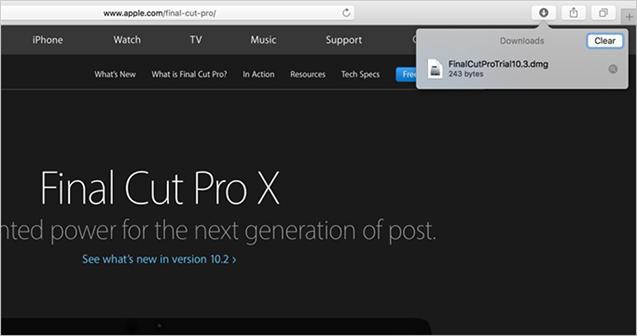

덧붙여, 애플은 오는 10월 27일 오랜만에 ‘맥’에 관한 이벤트를 한다. ‘hello’는 1984년 매킨토시가 공개되었을 때 잡스가 선보인 문구다. 현재의 맥은 아이폰에 비하면 수익이 훨씬 적지만 애플 기술의 집합체가 맥이라 하여도 과언아니다. 애플이 맥에 소원한 것처럼 보이지만 아이폰에 비해 관심이 낮아졌기에 오히려 맥 하드웨어에 보다 다양한 기능을 여유롭게 집어넣을 수 있게 되었다. 터치ID(지문 인식), OLED 터치바, USB-C 지원 맥세이프 파워어댑터 등 필자 또한 맥 하드웨어에 변경사항에 관심이 간다. 더불어 발표할 Final Cut Pro X 신버전 등 소프트웨어 또한 기다리고 있다. 맥은 아이폰의 과거지만 미래이기도 하기 때문이다.

애플이 생각하는 보는 것과 듣는 것! 컨텐츠 수요역할과 제작역할로 아이폰(iDevices)과 맥을 들여다볼 필요가 있다. 위에서 언급하다시피 애플은 오로지 컨텐츠에 관심을 가져왔다. 사람들이 감각으로 즐기 보는 건 사진을, 영상을 찍어 보는 것이다. 너무도 간단하고 단순한 이 생각을 다른 IT기업 보다 애플이 더 와 닿는 게 상품을 만드는 건 애플이 만들어 내는 기술이 인간의 감각에 보다 맞닿아 있기 때문이 아닐까 싶다. 3D 영상 기술 도입에 ‘No’라고 외친 애플이 그 기술을 원하는 많은 기업과 사람들에게는 억울하겠지만 타당해 보이기 때문이다. 현재까지 말이다.

10월 20일 실수로 공개된 Final Cut Pro X 10.3 다운로드 파일

지난 기사 [IT]애플이 생각하는 보는 것과 듣는 것 - 상편: 에어팟, 애플식의 듣는 것 |

trexx

트위터 : @trexxcom

편집 : 딴지일보 cocoa

![[수기]암에 걸렸다](https://img-cdn.ddanzi.com/files/thumbnails/380/780/138/200x126.crop.jpg) [수기]암에 걸렸다

물뚝심송

[수기]암에 걸렸다

물뚝심송

![[잡식]언젠간 쓸모 있을지 모를 짧은 지식 24(비선실세 특집)](https://img-cdn.ddanzi.com/files/thumbnails/439/478/139/200x126.crop.jpg)

추천

[잡식]언젠간 쓸모 있을지 모를 짧은 지식 24(비선실세 특집) 알려지지 않은 주시자![[박근혜최순실게이트]일단 박근혜 대통령부터, 끄자](https://img-cdn.ddanzi.com/files/thumbnails/427/457/139/200x126.crop.jpg)

추천

[박근혜최순실게이트]일단 박근혜 대통령부터, 끄자 물뚝심송![[딴지만평]세월호 참사 때도, 최순실은](https://img-cdn.ddanzi.com/files/thumbnails/162/484/139/200x126.crop.jpg) [딴지만평]세월호 참사 때도, 최순실은

zziziree

[딴지만평]세월호 참사 때도, 최순실은

zziziree

![[한동원의 적정관람료]로스트 인 더스트(Hell or High Water)](https://img-cdn.ddanzi.com/files/thumbnails/027/458/139/200x126.crop.jpg) [한동원의 적정관람료]로스트 인 더스트(Hell or High Water)

한동원

[한동원의 적정관람료]로스트 인 더스트(Hell or High Water)

한동원

![[창조외국어]아무데서도 안 가르쳐주는 오늘의 생활단어 : '최순실' 편](https://img-cdn.ddanzi.com/files/thumbnails/874/216/139/200x126.crop.jpg)

추천

[창조외국어]아무데서도 안 가르쳐주는 오늘의 생활단어 : '최순실' 편 챙타쿠![[박근혜최순실게이트]죄 지은 자가 심판받지 않는 세상](https://img-cdn.ddanzi.com/files/thumbnails/799/227/139/200x126.crop.jpg)

추천

[박근혜최순실게이트]죄 지은 자가 심판받지 않는 세상 춘심애비![[딴지만평]純실데렐라 : 유리구두 대신 프라다가 벗겨진, 현 대한민국 최고의 셀레브리티](https://img-cdn.ddanzi.com/files/thumbnails/349/227/139/200x126.crop.jpg) [딴지만평]純실데렐라 : 유리구두 대신 프라다가 벗겨진, 현 대한민국 최고의 셀레브리티

zziziree

[딴지만평]純실데렐라 : 유리구두 대신 프라다가 벗겨진, 현 대한민국 최고의 셀레브리티

zziziree

![[가자]11월 12일을 위하여(백남기, 한상균과 함께)](https://img-cdn.ddanzi.com/files/thumbnails/104/090/139/200x126.crop.jpg)

추천

[가자]11월 12일을 위하여(백남기, 한상균과 함께) 산하![[정치]전직 부장판사가 알려주는, 대통령을 탄핵하려면 어떤 절차가 필요할까](https://img-cdn.ddanzi.com/files/thumbnails/300/089/139/200x126.crop.jpg) [정치]전직 부장판사가 알려주는, 대통령을 탄핵하려면 어떤 절차가 필요할까

이정렬

[정치]전직 부장판사가 알려주는, 대통령을 탄핵하려면 어떤 절차가 필요할까

이정렬

![[국제]박근혜 탄핵이 검색어 순위 오른 김에 알아보는 전세계 대통령 탄핵 사례 모음](https://img-cdn.ddanzi.com/files/thumbnails/459/989/138/200x126.crop.jpg) [국제]박근혜 탄핵이 검색어 순위 오른 김에 알아보는 전세계 대통령 탄핵 사례 모음

양평김한량

[국제]박근혜 탄핵이 검색어 순위 오른 김에 알아보는 전세계 대통령 탄핵 사례 모음

양평김한량

![[현장스케치]10월 29일 촛불집회: "박근혜는 퇴진하라"](https://img-cdn.ddanzi.com/files/thumbnails/608/985/138/200x126.crop.jpg)

추천

[현장스케치]10월 29일 촛불집회: "박근혜는 퇴진하라" 좌린![[박근혜최순실게이트]우리는 ‘최순실’을 정산 받았다 - 사려 없는 욕망은 빚으로 되돌아온다](https://img-cdn.ddanzi.com/files/thumbnails/605/779/138/200x126.crop.jpg)

추천

[박근혜최순실게이트]우리는 ‘최순실’을 정산 받았다 - 사려 없는 욕망은 빚으로 되돌아온다 필독![[국제]두테르테의 마약 캠페인, 'OPLAN TOKHANG'은 초법적 살인인가](https://img-cdn.ddanzi.com/files/thumbnails/515/785/137/200x126.crop.jpg) [국제]두테르테의 마약 캠페인, 'OPLAN TOKHANG'은 초법적 살인인가

삐약

[국제]두테르테의 마약 캠페인, 'OPLAN TOKHANG'은 초법적 살인인가

삐약

![[딴지만평]박근혜 대통령, 지난 4년 업적 총정리](https://img-cdn.ddanzi.com/files/thumbnails/898/465/138/200x126.crop.jpg) [딴지만평]박근혜 대통령, 지난 4년 업적 총정리

zziziree

[딴지만평]박근혜 대통령, 지난 4년 업적 총정리

zziziree

![[공구의 4컷]JTBC의 팩트폭력(feat. 계엄)](https://img-cdn.ddanzi.com/files/thumbnails/203/439/138/200x126.crop.jpg) [공구의 4컷]JTBC의 팩트폭력(feat. 계엄)

공구

[공구의 4컷]JTBC의 팩트폭력(feat. 계엄)

공구

![[리뷰]본격 순실리티 게임, '근혜테일'의 몰살루트 엔딩(스포주의)](https://img-cdn.ddanzi.com/files/thumbnails/009/420/138/200x126.crop.jpg)

추천

[리뷰]본격 순실리티 게임, '근혜테일'의 몰살루트 엔딩(스포주의) 우켈켈박사![[정치]박근혜 게이트, 청와대의 다음 카드는?: 개헌이냐 전쟁이냐](https://img-cdn.ddanzi.com/files/thumbnails/298/239/138/200x126.crop.jpg)

추천

[정치]박근혜 게이트, 청와대의 다음 카드는?: 개헌이냐 전쟁이냐 펜더![[IT]애플이 생각하는 보는 것과 듣는 것 - 하편: 듀얼렌즈, 애플식의 보는 것](https://img-cdn.ddanzi.com/files/thumbnails/287/175/138/200x126.crop.jpg) » [IT]애플이 생각하는 보는 것과 듣는 것 - 하편: 듀얼렌즈, 애플식의 보는 것

trexx

» [IT]애플이 생각하는 보는 것과 듣는 것 - 하편: 듀얼렌즈, 애플식의 보는 것

trexx

![[역사]최순실 대통령(진)님 헌정, 한국사 샤먼킹의 역사](https://img-cdn.ddanzi.com/files/thumbnails/133/045/138/200x126.crop.jpg) [역사]최순실 대통령(진)님 헌정, 한국사 샤먼킹의 역사

빵꾼

[역사]최순실 대통령(진)님 헌정, 한국사 샤먼킹의 역사

빵꾼

검색어 제한 안내

입력하신 검색어는 검색이 금지된 단어입니다.

딴지 내 게시판은 아래 법령 및 내부 규정에 따라 검색기능을 제한하고 있어 양해 부탁드립니다.

1. 전기통신사업법 제 22조의 5제1항에따라 불법촬영물 등을 기재(유통)시 삭제, 접속차단 등 유통 방지에 필요한 조치가 취해집니다.

2. 성폭력처벌법 제14조, 청소년성처벌법 제11조에 따라 불법촬영물 등을 기재(유통)시 형사 처벌을 받을 수 있습니다.

3. 『아동·청소년의 성보호에 관한 법률』 제11조에 따라 아동·청소년이용 음란물을 제작·배포 소지한 자는 법적인 처벌을 받으실 수 있습니다.

4. 정보통신망 이용촉진 및 정보보호 등에 관한 법률 및 시행령에 따라 청소년 보호 조치를 취합니다.

5. 저작권법 제103조에 따라 권리주장자의 요구가 있을 시 복제·전송의 중단 조치가 취해집니다.

6. 내부 규정에 따라 제한 조치를 취합니다.